Створивши для роботів ситуацію етичного вибору – кого з двох осіб, які одночасно потрапляють в небезпеку, треба рятувати – вчені з’ясували, що найбільше смертей приносить не сам вибір, а надто довгі роздуми машини. Про свої експерименті Алан Вінфілд (Alan Winfield) з Бристольскої лабораторії робототехніки розповів на конференції по автономним роботам, яка пройшла 2 вересня в Бірмінгемі.

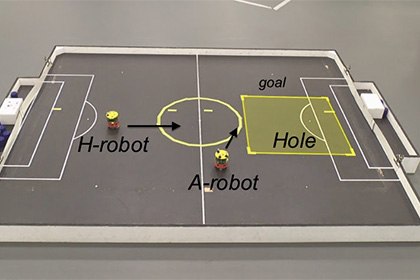

Вінфілд запрограмував робота утримувати інші автомати (які зображували людей) від падіння в яму. Такий експеримент являє собою, по суті, ілюстрацію до першого закону робототехніки А. Азімова: «Робот не може заподіяти шкоду людині або своєю бездіяльністю допустити, щоб людині була заподіяна шкода».

Читайте також: На зміну футболістам йдуть роботи — відео

Спочатку у машини проблем не виникло: як тільки «людина» наближалася до ями, робот швидко відсував її від небезпечного місця. Але коли вчені додали другий автомат, що наближався до пастки з тією ж швидкістю, перед роботом постала дилема – кого рятувати першим. Іноді йому вдавалося втримати одну «людину», пару раз – двох, але в 14 випадків з 33 робот стільки часу витрачав на етичні міркування, що обидву «людини» падали в яму.

Вінфілд визнає невтішні результати свого експерименту і підкреслює, що роботи все ще залишаються «етичними зомбі»: вони, здатні дотримувати певний кодекс поведінки, але не розуміють його моральних підстав.

Навчити машини приймати етичні рішення можуть фахівці з військової робототехніки. Рональд Аркін (Ronald Arkin) розробив набір алгоритмів («етичний керівник»), який покликаний допомогти роботам діяти на полі бою: в яких ситуаціях припиняти вогонь, в якій обстановці (біля школи чи лікарні, наприклад) прагнути звести до мінімуму кількість жертв.

Читайте також: Роботи-солдати: що чекає світ в недалекому майбутньому?

Аркін вважає, що навчити моралі військових роботів буде найпростіше, оскільки закони війни є чіткими і прописані в міжнародних договорах. На відміну від живих солдатів, схильних до емоцій і афектам, машини ніколи не порушать ці закони.