OpenAI розпочала навчання своєї нової “граничної” моделі, яка, за їхніми очікуваннями, наблизить досягнення загального штучного інтелекту (AGI). Однак, щоб вирішити потенційні ризики, пов’язані з потужним ШІ, компанія створила новий комітет, присвячений безпеці. Цей орган консультуватиме раду директорів щодо важливих рішень, що стосуються безпеки проєктів і операцій OpenAI. Про це повідомляється на офіційному сайті компанії.

Компанія зазначає, що для оцінки ризиків потрібно 90 днів, і протягом цього часу новий продукт не буде випущено. Рішення про створення комітету викликало певну критику. Деякі експерти вважають, що комітет не є незалежним, оскільки до його складу входять виключно керівники OpenAI, зокрема Сем Альтман, генеральний директор компанії.

Компанія наголошує на важливій ролі нового комітету в розвитку прикордонної моделі штучного інтелекту. Першим завданням комітету стане оцінка та подальший розвиток процесів і заходів безпеки протягом наступних 90 днів. Після цього комітет поділиться своїми рекомендаціями з радою директорів. Після розгляду, OpenAI публічно оприлюднить інформацію про прийняті рекомендації.

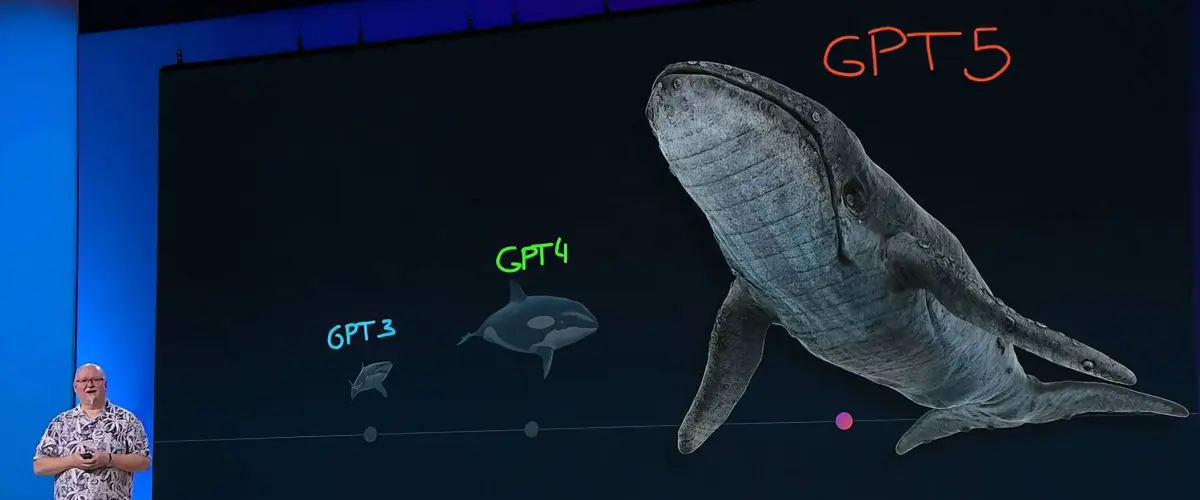

Таким чином, незалежно від того, як називатиметься нова модель — GPT-5 чи інакше, її випуск відкладено на щонайменше 90 днів. Цей час необхідний новому комітету з безпеки та захисту для оцінки та подальшого розвитку заходів безпеки OpenAI і підготовки рекомендацій для ради директорів. Очікується, що рада директорів OpenAI отримає рекомендації нового комітету не пізніше 26 серпня 2024 року.

На чолі комітету стоїть Брет Тейлор, голова ради директорів OpenAI, співзасновник Sierra AI, колишній керівник Google Maps і колишній технічний директор Facebook. Також до складу комітету входять Адам Д’Анджело, генеральний директор Quora і творець застосунку-агрегатора моделей штучного інтелекту Poe, Ніколь Селігман, колишній виконавчий віцепрезидент і головний юрисконсульт Sony Corporation, і Сем Альтман, генеральний директор і співзасновник OpenAI.

Новина про створення комітету викликала критику через те, що він складається з “власних керівників” OpenAI, що означає відсутність незалежної оцінки заходів безпеки компанії. Деякі експерти вважають це підходом до саморегулювання, який не забезпечує реального нагляду.

Раніше рада директорів OpenAI була джерелом суперечок. У листопаді 2023 року вони звільнили Сема Альтмана з посади генерального директора, але під тиском співробітників та інвесторів були змушені відновити його. Раду також критикували за те, що вона складалася лише з чоловіків. Нещодавно два співкерівники команди суперузгодження OpenAI — Ілля Суцкевер і Ян Лейке — подали у відставку, а команду, яка фокусувалася на пом’якшенні ризиків надінтелектуального ШІ, було розформовано.