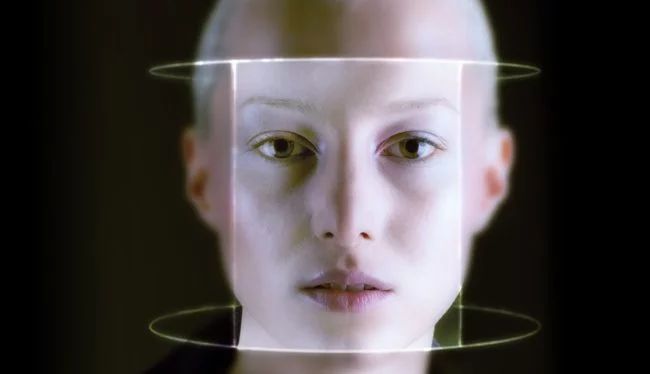

Розробкою системи розпізнавання осіб займається практично кожна технологічна компанія. Однією з них є Amazon — її технологія називається Rekognition і, на думку фахівців з Массачусетського технологічного інституту, вона сильно поступається своїм аналогам. Річ у тому, що в ході оцінки її точності з’ясувалося, що система часто не може розрізнити стать чорношкірих людей. Це вже друга скарга на образливу роботу розпізнавання осіб Amazon.

Вчені перевіряли роботу штучного інтелекту Rekognition протягом усього 2018 року. Кількість помилок при визначенні статі чорношкірих людей сягала 31% і це, на думку дослідників, це жахливий результат. Для порівняння, розпізнавання осіб Microsoft допускає подібні помилки лише в 1,5% випадків.

Компанія Amazon вважає, що претензії дослідників позбавлені підстав. Вона запевнила, що у внутрішніх тестах оновленої версії Rekognition не було помічено жодної шибки. Дослідники звернули увагу, що співробітники MIT не назвали рівень точності, при досягненні якої робота штучного інтелекту Amazon вважалася «правильною».

За словами генерального директора по глибокому навчанні Amazon Web Services Метта Вуда, вони самостійно перевірили систему, використовуючи мільйон зображень осіб з бази даних Megaface. В ході тестування штучний інтелект не допустив жодної помилки. При цьому представник компанії оголосив, що вони готові прислухатися до результатів сторонніх тестів для того, щоб поліпшити свій продукт.

Це далеко не перший випадок, коли штучний інтелект Amazon опинився в центрі скандалу. Влітку 2018 року він прийняв 28 членів Конгресу за злочинців, причому 38% з них були чорношкірими.

З подібними скандалами мали справу і інші компанії. На щастя, вони отримують уроки з ситуацій і постійно покращують технології. В червні Microsoft розширила кількість даних, що використовуються при розпізнаванні осіб — зокрема, система почала більше звертати увагу на стать, вік і відтінок шкіри. Це зменшило кількість помилок при сортуванні чоловіків і жінок до 20 разів.