Неврологи з Пітсбурзького університету розробили модель машинного навчання, яка показала, як мозок розпізнає значення комунікативних сигналів, таких як заклики тварин або слова людської мови. Ця модель може стати основою інтелектуальних слухових апаратів.

У роботі вчених Піттсбурзького університету описаний алгоритм роботи мозку при розпізнаванні комунікативних сигналів. Алгоритм показав, як соціальні тварини, включаючи мармозетів або морських свинок, використовують спеціальні нейронні мережі для обробки звуку, щоб точно розрізняти комунікативні сигнали, наприклад, заклики до спаровування, їжі або повідомлення про небезпеку.

Це дослідження є важливим кроком до розуміння тонкощів роботи нейронів, що лежать в основі розпізнавання звуків. Результати цієї роботи дозволять в кінцевому підсумку лікувати розлади, що впливають на розпізнавання мови і можуть поліпшити слухові апарати, зробивши їх не тільки підсилювачами звуку, але інтелектуальними пристроями.

“Навряд чи кожна людина, в якийсь момент свого життя починає втрачати слух. Це відбувається або в результаті старіння, або в результаті постійного впливу шуму. Розуміння біології розпізнавання звуків і пошук шляхів її поліпшення дуже важливі», — говорить співавтор роботи Пітта Шріватсун Садагопан, — «Але процес мовного спілкування захоплюючий і сам по собі. Як наш мозок при взаємодії з іншим мозком сприймає ідеї і передає їх за допомогою звуків, не що інше, як диво».

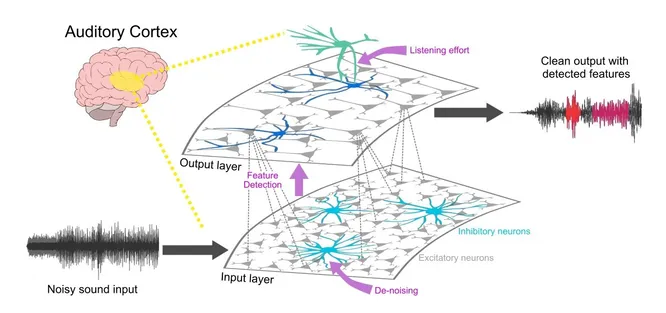

Схема моделі розпізнавання звукових сигналів Manaswini Kar https://www.nature.com/articles/s42003-023-04816-z шумні вхідні сигнали проходять через мережі збудливих і гальмівних нейронів у слуховій корі, які очищають сигнал (частково під керівництвом слухача, який зосереджує свою увагу) і виявляють характерні особливості звуків, дозволяючи мозку розпізнавати комунікативні звуки незалежно від того, як вони вимовляються оратором і наскільки заважає навколишній шум.

Люди і тварини щодня чують разючу різноманітність звуків — від какофонії джунглів до гулу в жвавому ресторані. Незалежно від рівня шуму світу, що оточує нас і люди та інші тварини здатні спілкуватися і розуміти один одного, незалежно від висоти голосу або акценту.

Наприклад, коли ми чуємо слово «Привіт», ми розуміємо його значення незалежно від того, з яким акцентом воно було вимовлено, жінка це сказала або чоловік, знаходимося ми в тихій кімнаті або на жвавому перехресті.

Команда припустила, що спосіб, яким людський мозок розпізнає і вловлює сенс комунікативного сигналу схожий на те, як мозок відрізняє обличчя від всіх інших об’єктів. Обличчя дуже різноманітні, але мають деякі загальні характеристики.

Замість того щоб зіставляти кожне обличчя, з яким ми стикаємося, з якимось ідеальним «шаблонним» обличчям, наш мозок відзначає корисні особливості: очі, ніс і рот, їх взаємне розташування, і створює уявну карту характеристик, що визначають обличчя.

Морські свинки та люди

У серії досліджень команда показала, що звуки спілкування теж складаються з характеристик, подібних характеристикам обличчя. Спочатку дослідники побудували модель машинного навчання для розпізнавання різних звуків, що видаються соціальними тваринами.

Щоб перевірити, чи відповідають реакції мозку цій моделі, вони записали мозкову активність морських свинок, слухаючи звуки спілкування своїх родичів. Нейрони в областях мозку, відповідальних за обробку звуків, «загорялися», коли тварини чули шум, що має характеристики комунікативних сигналів.

Потім вчені вирішили перевірити ефективність моделі на реальній поведінці тварин. Морських свинок помістили у вольєр і піддали впливу різних комунікативних звуків — писку і рохкання. Потім дослідники навчили морських свинок ходити в певний кут вольєра і отримувати смачні фрукти в залежності від того, які звуки відтворювалася.

На наступному кроці вчені ускладнили завдання: щоб імітувати те, як люди розпізнають значення слів, вимовлених різними голосами. Дослідники пропускали звукові сигнали морських свинок через програмне забезпечення, що змінює звук — – прискорювали або уповільнювали темп, підвищували або знижували висоту, додавали шум і відлуння.

Тварини прекрасно впоралися і з цим завданням. Щобільше, модель машинного навчання чудово описала їх поведінку (і основну активацію нейронів мозку, що обробляють звук).

Наступним кроком дослідники збираються перенести модель з тварин на людську мову.